El chip IA SN40L es capaz de ejecutar hasta 5 trillones de parámetros, permitiendo una inferencia rápida y escalable sin sacrificar la precisión.

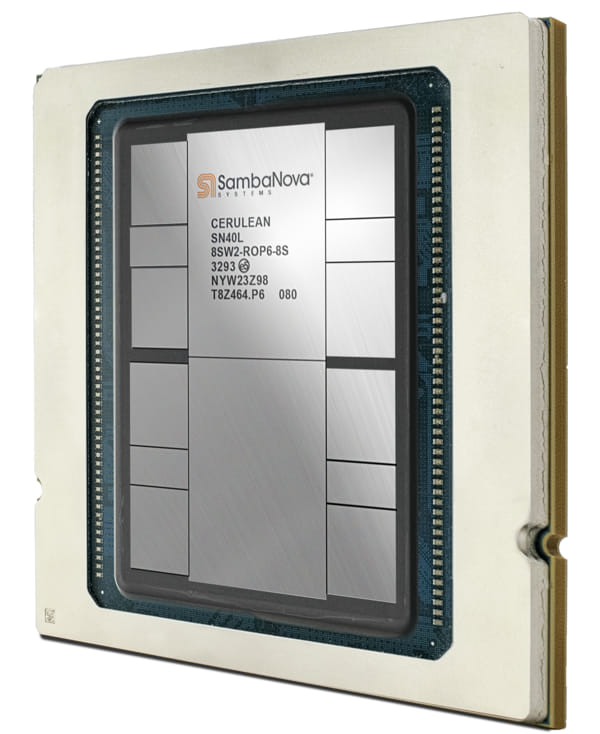

SambaNova Systems anuncia el chip “inteligente” SN40L para la plataforma de modelo de lenguaje colosal (LLM) SambaNova Suite, que ofrece funciones de computación e incluye una memoria grande y rápida.

Fabricado por TSMC, el SN40L de SambaNova puede servir a un modelo de 5 trillones de parámetros, con una longitud de secuencia de 256k+ en un nodo de sistema. Esto solamente es posible con una pila integrada y un buen número de mejoras con respecto a los anteriores chips, respaldando modelos de mayor calidad, con una inferencia más rápida y un menor coste total de propiedad (TCO).

Así, el nuevo chip es un elemento más de la plataforma LLM full–stack de SambaNova, que intenta hacer frente a los grandes retos al desplegar inteligencia artificial (IA) generativa. Así, permite a los clientes agregar modalidades y experiencia en nuevas áreas y aumentar el recuento de parámetros del modelo (hasta 5T) sin comprometer el rendimiento de la inferencia.

«El SN40L cumple los requisitos de elevada memoria de ancho de banda (HBM) y DRAM en un solo chip, haciendo posible que los algoritmos IA “elijan” la memoria más apropiada para cada tarea. Y, usando la arquitectura de unidad de datos reconfiguradle (RDU), los chips se pueden beneficiarse de unas prestaciones informáticas más inteligentes”, señala Peter Rutten, Vicepresidente de Investigación de IDC.

Nuevos modelos y capacidades

Las versiones Llama2 (7B y 70B) ofrece unos modelos de lenguaje de código abierto que ayuda a los clientes a adaptar, ampliar y ejecutar los mejores modelos LLM, mientras que la variante BLOOM 176B dota de un modelo de fundación multilingüe en una comunidad de código abierto para solventar los problemas y soportar nuevos lenguajes.

Un nuevo modelo para la generación aumentada de recuperación basada en vectores permite a los clientes incorporar sus documentos en incrustaciones de vectores, que pueden recuperarse durante el proceso de preguntas y respuestas. Después, el LLM recoge los resultados para analizar, extraer o resumir la información.

Las novedades se completan con un modelo de reconocimiento de voz automatizado para transcribir y analizar datos de voz, funciones adicionales multimodales y de secuencia larga y sistemas optimizados para inferencia con memoria Dataflow de 3 niveles para contar con un gran ancho de banda y alta capacidad.

Finalmente, en el “Servicio al lector de NTDhoy” puedes solicitar más información.